CVPR 2025 Oral | VideoEspresso: 基于核心帧和关键物体时空推理的大规模链式思维数据集和评测基准

项目简介

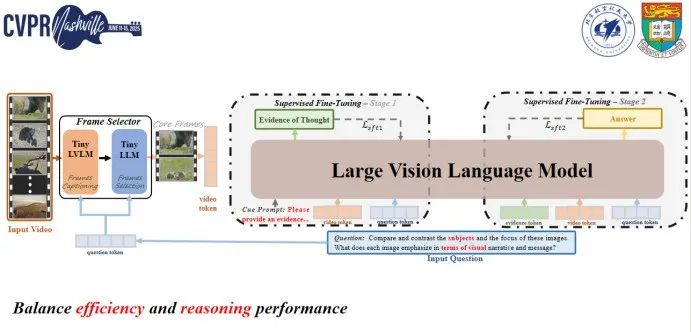

大型视觉语言模型(LVLMs)的发展显著提升了多模态理解能力,但在视频推理任务中仍面临挑战,主要是由于缺乏高质量、大规模的数据集。现有的视频问答(VideoQA)数据集通常依赖于成本高昂的手动标注,且缺乏细粒度细节,限制了其可扩展性。而自动构建方法则因逐帧分析导致的冗余和计算成本过高而效果受限。为解决这些挑战,我们提出了 VideoEspresso,这是一个新的数据集,包含保留了空间细节和时间连贯性的VideoQA对,以及多模态中间推理步骤的标注。我们的构建流程采用语义感知方法减少冗余,然后利用GPT-4o生成QA对。我们进一步开发了视频链式思考(Chain-of-Thought, CoT)标注来丰富推理过程,指导GPT-4o从QA对和视频内容中提取有助于答案的逻辑关系证据,包括关键对象在时空流中的交互。通过标注这些逻辑过程,我们旨在扩展QA数据集上的推理证据链。为了充分利用高质量的VideoQA对,我们提出了一个混合LVLM协作框架,包括一个帧选择器和一个两阶段指令微调的推理LVLM。该框架自适应地选择与问题最相关的核帧,并使用多模态证据进行链式思考推理。我们在提出的基准测试中对14个任务进行了评估,对比了9种流行的LVLMs,我们的方法在大多数任务上优于现有的基线,展现出卓越的视频推理能力。

论文地址:

https://arxiv.org/pdf/2411.14794

项目代码:

https://github.com/hshjerry/VideoEspresso

在常见的视频数据中,即使是一些通用基准测试所采用的较短视频,其帧数仍然非常可观。以时长约为1至2分钟的短视频为例,其帧数通常可达数百甚至上千帧。在当前主流的视觉-语言大模型中,即便采用每秒1帧(FPS=1)的极低频率进行采样,最终仍需输入超过200帧至模型进行推理。如此高的数据冗余对模型的可移植性构成了严重挑战,导致许多模型架构或计算资源(如通用显卡)难以满足其推理需求,即使面对的任务仅为相对简单的问答任务。

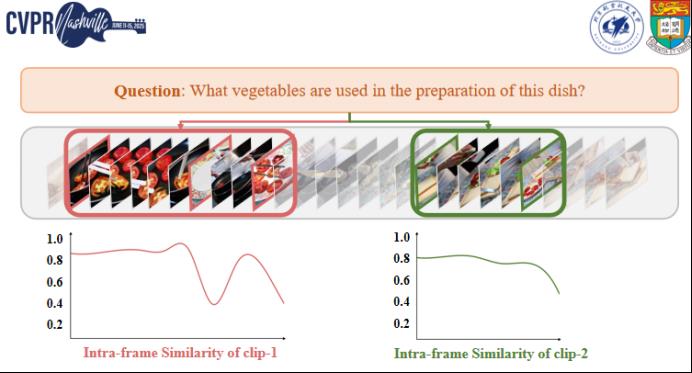

通过对视频数据的观察,我们发现视频帧中普遍存在较为严重的冗余现象。以一个具体示例为例,在某段视频中,大量连续帧聚焦于同一种蔬菜,如前几帧呈现的是西红柿,随后的一系列帧则持续显示在案板上的相同物体,整体内容未发生明显变化。在这些帧之间,不论是帧间的视觉差异,还是帧内物体的数量、类别及空间位置均保持高度一致。这一现象表明,相邻帧之间存在高度冗余性,大量信息重复且对任务无实质增益。因此,我们提出一个关键问题:在进行视频推理时,是否有必要保留所有帧?是否可以仅保留关键帧,以显著减少输入冗余,从而提高推理效率与系统可扩展性?

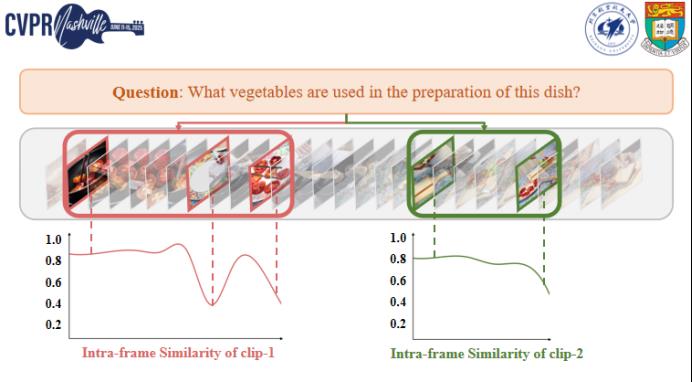

为进一步验证视频中帧冗余的存在,我们采用基于clip的帧间相似性分析(来观察帧之间的相关性。如图所示,我们对视频序列进行了切分,并对每个clip内部帧的相似性进行了计算与可视化。在第一个clip(如红框所示)中,连续帧之间表现出高度的视觉相似性,其相似度曲线大致维持在0.8左右,表明图像内容变化非常有限。尽管中间部分出现了轻微的场景变换,但整体趋势仍表现为高冗余性。

基于此观察,我们进一步尝试将原始包含数十帧的clip进行帧数压缩,仅保留其中三个关键帧用于模型推理。实验结果表明,在此压缩策略下,模型依然能够准确完成问答任务。这一现象不仅出现在第一个clip中,在第二个clip(如绿色框所示)中也有类似表现,其帧间相似度始终保持较高水平,仅需两帧即可有效覆盖该段视频所包含的关键信息。

综上所述,我们得出结论:对于如“该菜品使用了哪些蔬菜?”这类语义需求稳定的视频问答任务而言,仅需选取少量帧即可有效支撑模型完成推理,显著降低了计算开销并提升了系统推理效率。

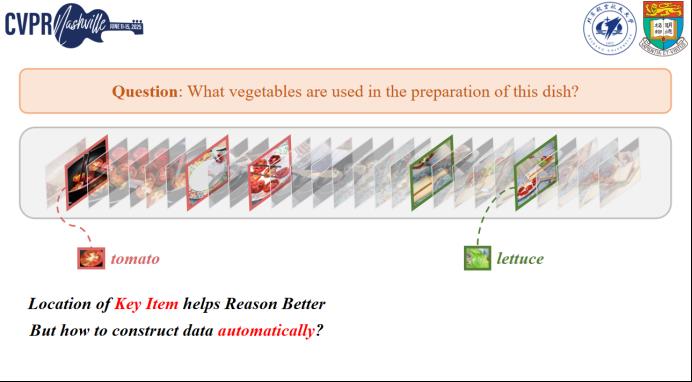

然而,一个核心问题是:仅使用少数帧是否就足够?我们的研究表明,答案是否定的。在视频中,某些帧虽然冗余,但其中包含的关键物体(key items)对任务理解至关重要。这一点也在已有的研究中得到广泛认可,无论是基于单张图像、多个图像,还是完整视频的视觉语言任务,关键物体始终发挥着核心作用。

以我们分析的视频片段为例,第一个clip主要呈现的是tomato,而第二个clip中则出现了lettuce。每个物体都与问题密切相关,比如“这道菜用了哪些蔬菜?”——显然,仅靠抽取帧本身还不够,还需识别帧内的重要语义元素。如果这些关键物体未被输入,现有的大规模视觉语言模型往往难以准确理解视频内容,我们的实验证实了这一点。

进一步地,我们发现:当我们将这些key items进行标注,并与高效的帧选择机制相结合输入模型时,不论是开源还是闭源的视觉语言模型,其在相关任务中的表现都有显著提升。

但问题也随之而来:是否需要为每个问题都手动标注关键帧和关键物体?显然,这种方式效率低下,难以扩展。因此,我们工作的核心目标,是构建一套数据机制,使模型能够自动选择关键帧并识别关键物体,并以可解释的推理方式辅助视频理解。

在传统的Common Video QA任务中,常见流程是直接基于完整视频,通过人工标注或借助如ChatGPT等大模型辅助生成问题与答案对(QA pairs)。然而,这类方式在效率与复杂度控制上存在显著局限。

为此,我们提出了VideoEspresso——一个全自动构建的视频问答数据集,其核心理念是围绕视频中的关键帧(key frames)与关键物体(key items)进行精炼建模,并引入具备推理能力的问题构建机制,使其更贴近真实场景中的复杂理解需求。

VideoEspresso的构建流程主要包括以下几点:

1.关键帧选取(Key Frame Selection):我们不再处理全量帧,而是通过自动机制挑选出对语义最关键的少量帧,作为后续建模的基础输入。

2.问题生成与筛选(Challenging Question Construction):所有问题均基于所选关键帧自动生成。我们特别强调问题的复杂性,因此过滤掉了大量简单问题,确保保留的问答对具有挑战性和推理需求。

3.推理路径构建(Chain-of-Thought Construction):在QA对之间,我们引入了中间证据项作为模型推理的重要桥梁。这种从key frames → captions → key items → evidence → answer的设计,显著增强了问题的可解释性与任务深度,也符合当前视觉语言模型“阅读理解式推理”的发展趋势。

我们提出了一套初步框架,用于系统性地组织关键帧、关键物体以及对应的时序与逻辑信息。

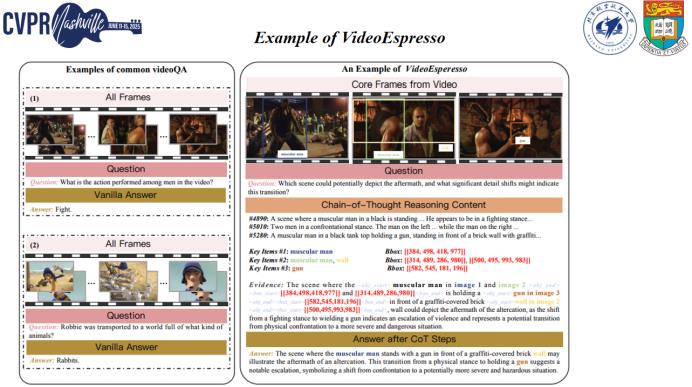

如图所示,我们展示了几个典型示例,包括切菜、打码球和冲浪等场景。对于每个视频,我们的数据集提供三类核心信息:

多样化的问题类型:涵盖从简单识别到复杂推理的问题,覆盖不同语义层级;

帧内关键物体信息:包括每个关键帧中的关键物体及其bounding box,用以提供精确的空间位置;

自然语言推理证据:我们构建跨帧一致性或变化的语义链条,将关键物体在时间维度上的演变以自然语言描述出来,作为辅助推理生成答案的依据。

这三部分共同构成了我们数据集的结构。

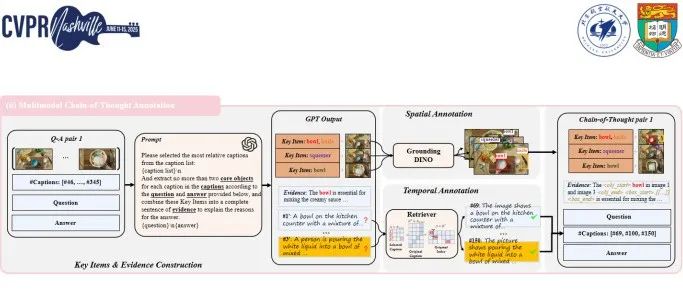

在本部分中,我们进一步介绍数据集的自动构建流程,其核心目标是构造高质量的多帧关联问答对,以促进视觉语言模型对长视频的理解与推理能力。

首先,我们对视频的每一帧进行Frame-Level Captioning,提取自然语言形式的描述。相比于原始图像信号,语言表征更易被大语言模型理解,尤其是在复杂语义建模方面具备显著优势。

随后,我们引入前述的Core Frames Filtering机制,利用CLIP模型对帧间语义相似度进行评估,筛选出具有代表性的关键帧及其对应的caption。这些关键帧被组织成多个语义一致的frame group,为后续问答构建提供基础。

接下来,我们基于这些caption组,通过精心设计的prompt输入到GPT-4o中,自动生成问题-答案对(QA Pairs)。在设计过程中,我们引入多项约束,包括:问题需依赖多个帧信息、涉及一定的复杂推理、视频字幕与帧序列间需保持时序一致性。

此外,我们将生成的问题类型覆盖14类,包括空间理解、时序理解、动作识别、物体交互、推理分析等多种语义层级,以系统性评估模型的长视频理解能力。最后,生成的初始问答对将交由Claude模型进行质量校验,从中筛选出符合格式、语言自然、逻辑合理的高质量问答对,最终构成我们数据集的核心内容。

接下来构建好问答对后,在Video Espresso系统中,最关键的环节是利用物体的边界框以及若干关键帧来构建一套有序的推理过程,我们将其称为“evidence”。具体而言,基于前期生成的问答对,系统会自动构建相应的提示语。首先,对于这些关键帧,我们采用Grounding DINO模型来提取其中的特殊标注,即将关键物体的边界框精准标注出来。同时,结合关键物体的描述文本,分析它们在时间序列上的关联性,并将这些关键物体按照逻辑推理的方式组织成一个辅助理解的“evidence”结构。最终,整个数据集由三个部分组成:问题、证据以及答案。其中,证据部分包含了关键物体及其对应的边界框信息。

Video Espresso数据集基于一个开源的视频数据集构建而成,所有的内容均是在该开放资源上进行的扩展与加工。整个数据集的构建核心是围绕关键物体展开的,这些关键物体不仅参与了问答对的生成过程,同时也是构成推理证据的基础。

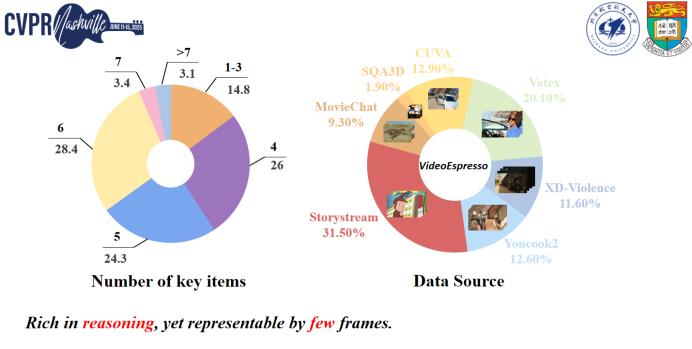

在构建过程中,我们对每个问题所涉及的关键物体数量进行了统计,如图左所示。数据显示,每个问题平均选取的关键物体数量通常在1到7之间,仅有不到4%的问题涉及的关键帧数量超过7帧,进入8至10帧的范围。这一统计结果反映出两个重要特征:其一,整个任务所依赖的关键物体数量较少;其二,所使用的帧数也相对精简。然而,即便在如此简洁的输入基础上,我们所构建的数据集在推理深度和复杂性上仍具备较强的表现力,这对于训练具备复杂推理能力的模型具有重要价值。

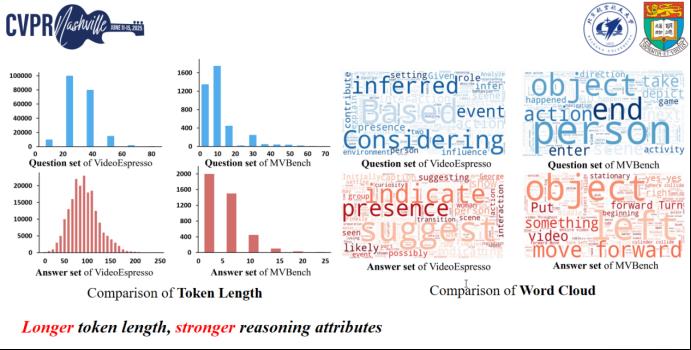

此外,我们还对Video Espresso中的问题与答案的长度分布进行了分析。从左图中的蓝色统计结果可以看出,每个问题的长度大多集中在20至40个token之间,这是一个标准且合理的区间。由于本数据集的问题设计偏向于复杂推理任务,相较于如MV-Bench等常规的视频理解基准,Video Espresso中问题的平均长度略有增加。

在答案部分,由于答案是基于evidence的综合推理结果,其平均长度也相对较长,大约为100个token左右。值得注意的是,我们的实验发现,在短视频理解任务中,完成一次有效的推理并不需要上千个token,通常100个token左右即可提供足够的信息以生成准确答案。

最后,我们也通过词云的方式分析了问题、答案以及evidence中的高频词汇。结果表明,该数据集在内容设计上高度聚焦于推理过程,reasoning贯穿于问题生成、证据构建以及答案生成的各个环节。因此,Video Espresso的显著特点之一便是其以推理能力为核心的数据构成方式。

在这一部分中,我们进一步通过一个具体示例说明了Video Espresso数据集的核心特性。如右图所示,该示例展示了我们从数据集中选取的一个典型片段,其中包含了人物在空间中的逻辑位置关系、对应的边界框标签,以及在问题下方通过evidence所构建的推理路径。在这一过程中,多个关键物体的边界框被有机地关联起来,形成了一个结构化的推理链条。这一机制实质上可视为一个reasoning process,与当前较为流行的“think step by step”类方法(如DeepSeek主导的思维链技术或GLPO算法引导的思考路径)在思想上具有一定的相似性。

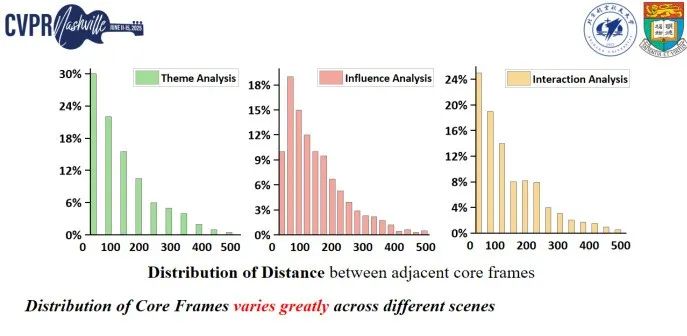

同时,我们还对数据中的关键帧间距进行了可视化分析。在实际统计中我们发现,部分关键帧之间的距离可能超过500帧。这意味着,如果采用传统的均匀采样策略,极有可能遗漏掉这些蕴含重要信息的关键帧。这一现象也从侧面反映出一个问题,即原始视频中的大量帧具有高度冗余性。因此,如何设计合理的帧选择机制,对于构建高效且信息密度高的推理任务具有重要意义。

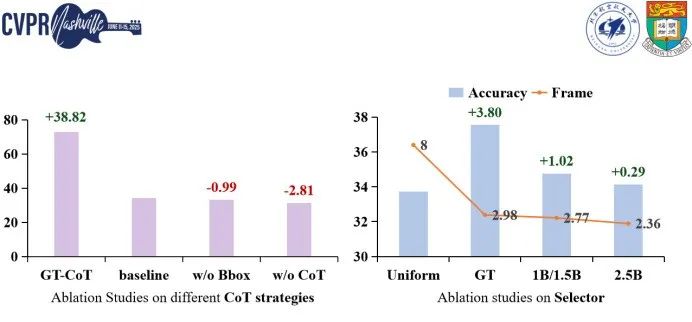

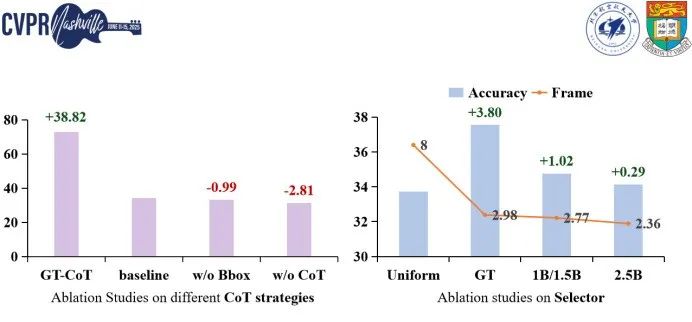

在模型训练方面,为了充分挖掘Video Espresso数据集的推理潜力,我们设计并实现了一套双阶段的训练流程,适用于我们构建的benchmark任务及大规模训练数据。具体而言,在第一阶段中,我们采用了一种轻量级的多模态视觉语言模型与小型语言模型协同工作,用于完成关键帧的筛选任务。在这一阶段,通过监督微调方式,使模型学习如何根据上下文信息生成结构化的evidence,从而具备初步的推理能力。

进入第二阶段后,我们将第一阶段生成的evidence作为输入,引导模型通过多轮对话的形式进行训练,使其进一步学习如何基于evidence生成高质量的答案。此阶段的目标是强化模型的推理表达能力和回答问题的连贯性,尤其是对时序关系与关键物体之间因果关联的理解。

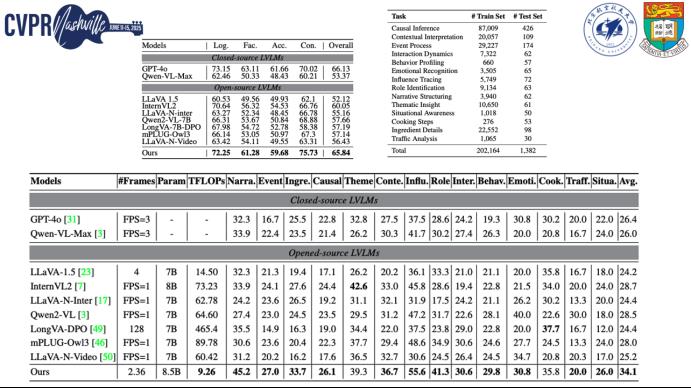

我们在构建的benchmark实验中,对比了多种闭源与开源模型的性能表现。表格中展示的结果表明,尽管Video Espresso数据集总体规模高达200K条样本,我们仅使用其中约1.3K条数据作为评估benchmark,但通过我们精细设计的训练流程,模型在复杂推理任务中的表现依然显著优于多数开源方案。这也反映出我们数据构建与训练策略在提升模型推理能力方面具有较强的有效性。

此外,我们还基于大模型与小模型协同的机制实现了高效的帧选择策略。这种设计不仅提高了训练效率,也为节约计算资源提供了可能。目前,Video Espresso也鼓励研究者在此基础上探索更多高效的帧选择方法,进一步推动视频理解任务的发展。

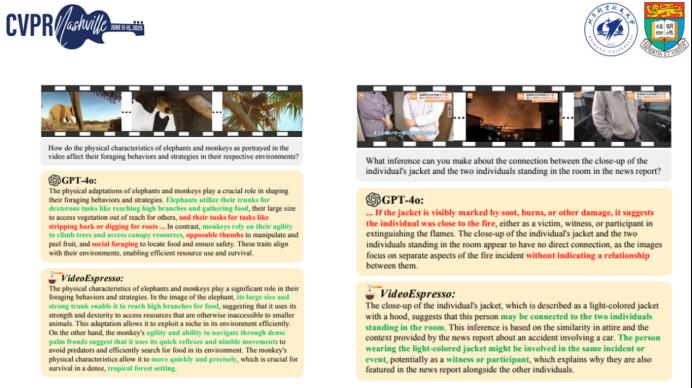

值得一提的是,在与GPT-4o的对比实验中,我们观察到经过Video Espresso训练的模型在处理答案生成时,能够更准确地识别并分析帧间的时间关系,并合理建模关键物体对最终答案的影响。这种对视频内容内在逻辑的精准把握,进一步验证了我们训练流程在提升多模态推理能力方面的独特优势。