终于发了!DeepSeek发布并开源V3.1,迄今为止最强大的开放AI

这一模型延续了DeepSeek-V3的强大能力,并在多个关键方面进行了升级。

01|模型参数与架构

DeepSeek-V3.1采用了改进的Transformer架构,总参数规模达到约6850亿。

其中采用了Mixture-of-Experts(MoE)稀疏专家方案,每个token推理时激活约370亿参数。

值得一提的是,DeepSeek-V3.1取消了传统MoE所需的负载均衡损失,避免了额外开销。

同时引入多token预测训练目标,进一步增强模型性能。

在训练过程中,DeepSeek团队使用了FP8混合精度和自研的DualPipe流水线并行算法,在2048张NVIDIA H800 GPU上完成了14.8万亿token的预训练,整个过程稳定高效,没有出现不可恢复的损失激增。

02|上下?窗?扩展

DeepSeek-V3.1最大的改进在于上下文长度的显著扩展。

新版本将模型的上下文窗口提升到128K tokens(约相当于300页文本)。

这意味着模型在一次交互中可以处理和记忆远超以往的信息量,能够支持更长的对话和更大规模的文档分析。

为了实现超长上下文,DeepSeek采用了名为YaRN(Yet another Random Noise)的位置编码扩展方案。

通过在长上下文训练中引入随机噪声扰动,模型在保持长程依赖建模能力的同时,有效缓解了长序列训练的不稳定问题。

实际测试显示,DeepSeek-V3.1在不同长度上下文下表现稳健,即使输入长达128K tokens时依然能够准确定位关键信息。

03|性能表现

凭借更大的参数规模和优化的训练策略,DeepSeek-V3.1在各项基准测试中表现优异。

综合评估显示,它不仅超越了此前所有开源模型的水平,而且在许多任务上达到了与领先闭源模型相当的性能。

例如, 在知识问答和推理测试(MMLU-Pro等) 上, DeepSeek-V3.1的准确率达到75.9%。

在数学和代码领域,该模型更是展现出强大实力:在MATH数学题基准上准确率超过90%。

在Codeforces编程竞赛评测中,其解题能力达到前51.6百分位,大幅领先其他开源模型。

在长文档理解的“大海捞针”(NeedleInAHaystack)测试中,DeepSeek-V3.1在不同长度上下文下均能保持高准确率,展现了扩展至128K后的稳健表现。

总体而言,DeepSeek-V3.1被认为是目前最强大的开源大模型。

04|开源与获取?式

DeepSeek-V3.1延续了DeepSeek一贯的开放策略,将模型权重和代码完全开源发布。

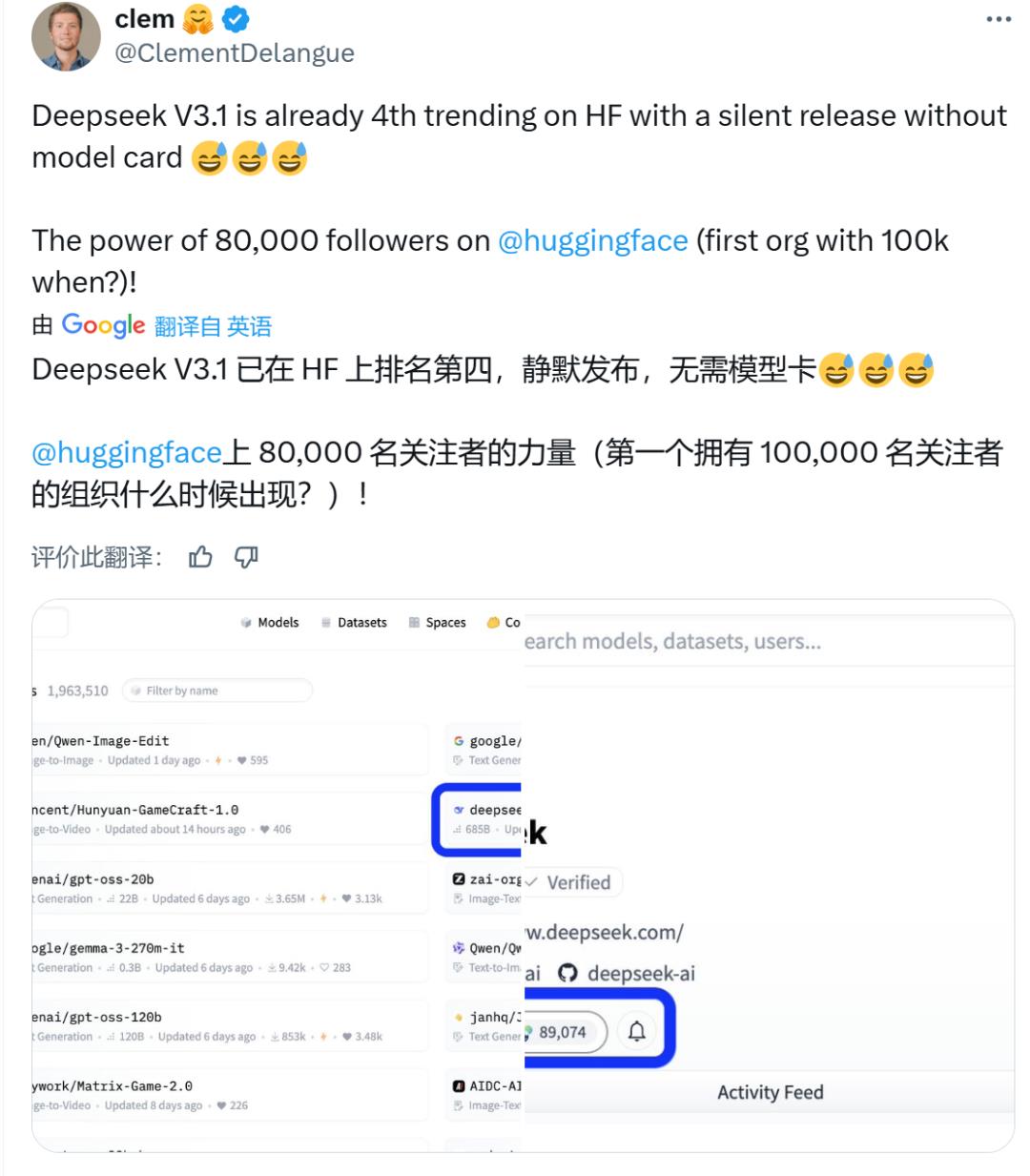

开发者可以在GitHub、Hugging Face等平台获取模型权重及推理代码。

DeepSeek官方还提供了多种本地部署方案和推理工具,包括轻量级的FP8/BF16推理演示、社区优化的推理框架(如LMDeploy、 vLLM等)以及分布式推理实现。

对于不具备大规模算力的用户,DeepSeek在其官方平台上提供了在线体验和API接口。用户现在可以通过网页端、对V3.1模型进行使用。