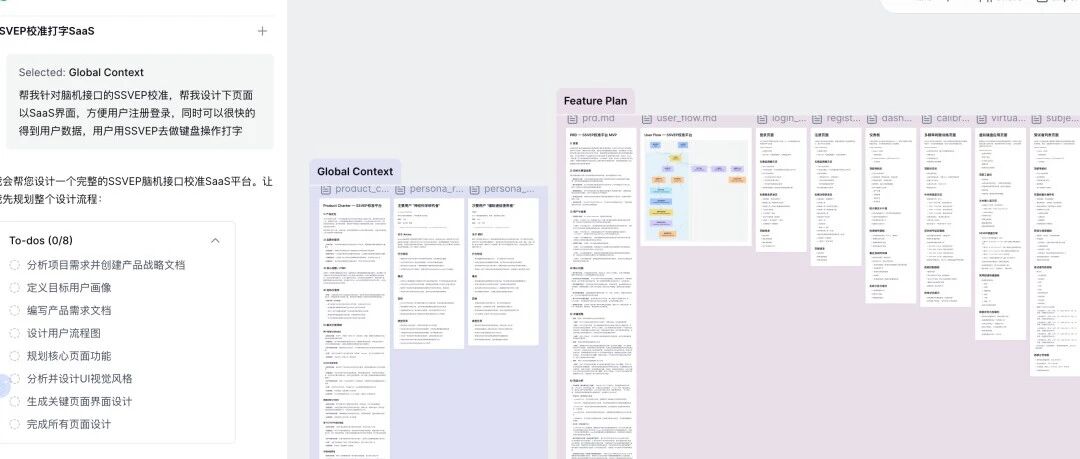

别再只谈模型了,Agent的“灵魂”在于上下文工程

但狂热之下,一个尴尬的现实摆在面前:为什么我们体验到的大部分Agent,都感觉有点“人工智障”?

它们要么在多轮对话中“失忆”,要么对你的真实意图一知半解,要么无法调用正确的工具,最终把一个简单的任务搞得一团糟。我们花了大力气选了最强的基座模型,设计了最酷的UI,结果用户一用,眉头一皱,默默关掉。

问题出在哪?

过去几个月,我一直在项目一线死磕这个问题。我的核心洞察是:我们过度关注了模型(LLM)的“大脑”,却严重忽略了Agent的“灵魂”——上下文工程(Context Engineering)。

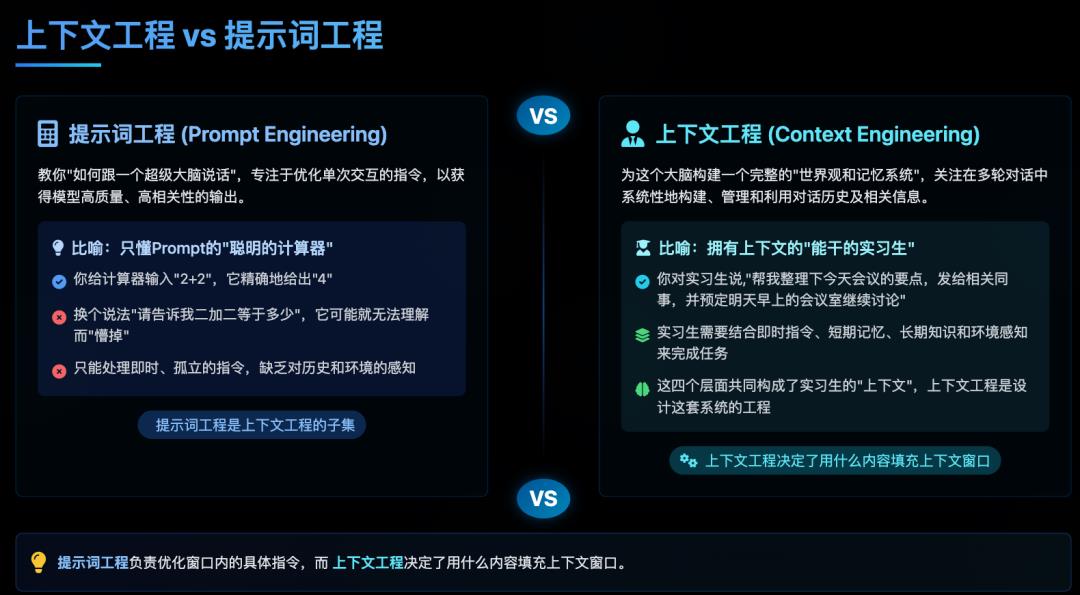

一、 什么是上下文工程?别把它和“提示词工程”搞混了

很多人一听“上下文”,第一反应就是“Prompt Engineering”。

如果说提示词工程是教你“如何跟一个超级大脑说话”,那么上下文工程就是为这个大脑构建一个完整的“世界观和记忆系统”。

我喜欢用一个比喻:你要的不是一个聪明的“计算器”,而是一个能干的“实习生”。

只懂Prompt: 你给计算器输入

2+2,它精确地给你4。你换个说法,它可能就懵了。拥有上下文: 你对实习生说,“帮我整理下今天会议的要点,发给相关同事,并预定明天早上的会议室继续讨论。”

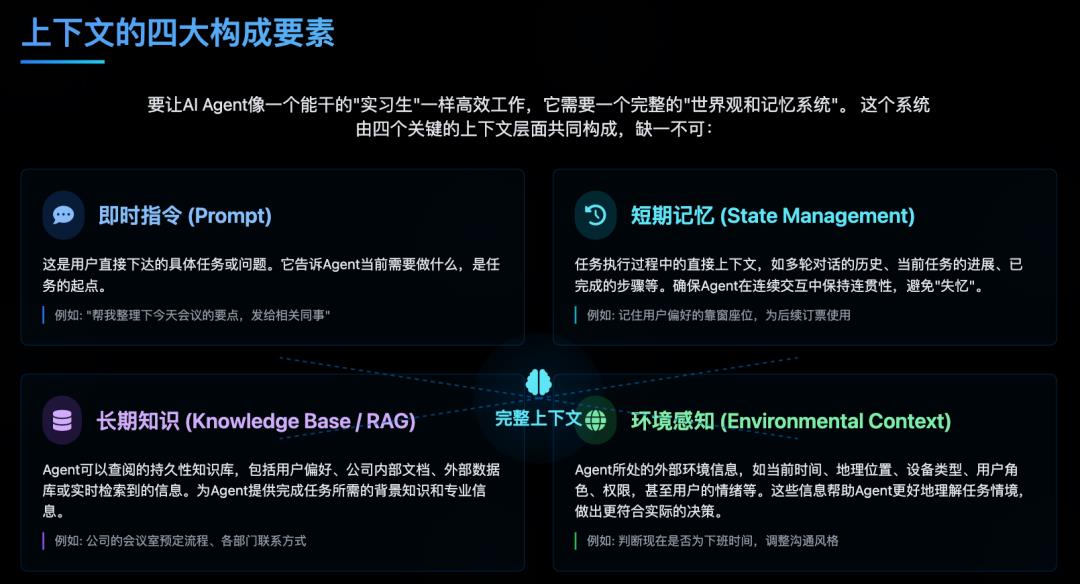

要完成这个任务,实习生需要什么?

即时指令 (Prompt): 你刚刚下达的具体任务。

短期记忆 (State Management): “今天会议”是哪个会议?会议记录在哪里?这是任务的直接上下文。

长期知识 (Knowledge Base / RAG): “相关同事”是谁?公司的会议室预定流程是怎样的?这需要他能查阅公司的知识库。

环境感知 (Environmental Context): 现在是下班时间吗?预定会议室需要考虑老板的日程吗?我是谁?我的偏好是什么?

这四个层面,共同构成了实习生的“上下文”。而上下文工程,就是我们作为产品经理和工程师,为AI Agent设计、搭建和维护这一整套信息处理系统的过程。 它是一个系统工程,远比写几句漂亮的Prompt要复杂。

二、 上下文,决定了Agent能力的上限

在Agent的构建中,基座模型决定了其智商的“下限”,它提供了基础的语言理解、推理和生成能力。但上下文工程,则决定了Agent实际表现的“上限”。

一个没有精心设计上下文的Agent,就像一个空有高智商却失忆、失明的实习生,无法在真实世界里解决任何有价值的问题。

案例1:失败的旅行规划Agent

我最近体验了一个号称能“一句话搞定旅行”的Agent。我告诉它:“下个月我想去云南玩一周,帮我规划下。”

它给出的路线非常标准,从昆明到大理再到丽江,看似完美。但我接着问:“我恐高,玉龙雪山可以换成别的吗?”

Agent:“好的,为您推荐香格里拉的普达措国家公园。”

我:“那从大理过去方便吗?”

Agent:“请问您从哪里出发?”

——你看,它“失忆”了。 它忘记了我们的对话是围绕“大理”展开的。这就是典型的短期记忆缺失。它把每一次交互都当成独立的请求,无法形成连贯的对话流,用户体验极差。、

一个优秀的Agent应该能无缝地维护对话状态,理解“那”和“过去”这类指代词的含义。

案例2:聪明的Coda AI

相比之下,一些头部产品在上下文工程上就做得非常出色。比如协同文档工具Coda的AI功能。

当你在Coda文档里@AI,让它“总结一下这个项目的风险点”,它能做到的不仅仅是文本总结。

它会扫描整个文档(RAG): 包括你写的文字、插入的表格、甚至关联的其他页面。

它会理解文档的结构(Environmental Context): 它知道哪些内容是“会议纪要”,哪些是“任务列表”。

它会结合你的身份(User Context): 如果你是项目经理,它可能会更侧重于时间和资源的风险。

最终,它给出的风险点总结,精准且深刻,因为它拥有了这个项目“完整”的上下文。它不仅仅是在处理语言,它在“理解”你的工作。这就是从“工具”到“队友”的跃迁,而这座桥梁,就是上下文工程。

三、 AI PM的核心战场:如何设计优秀的上下文系统?

既然上下文工程如此重要,我们作为AI PM,应该从哪里着手?

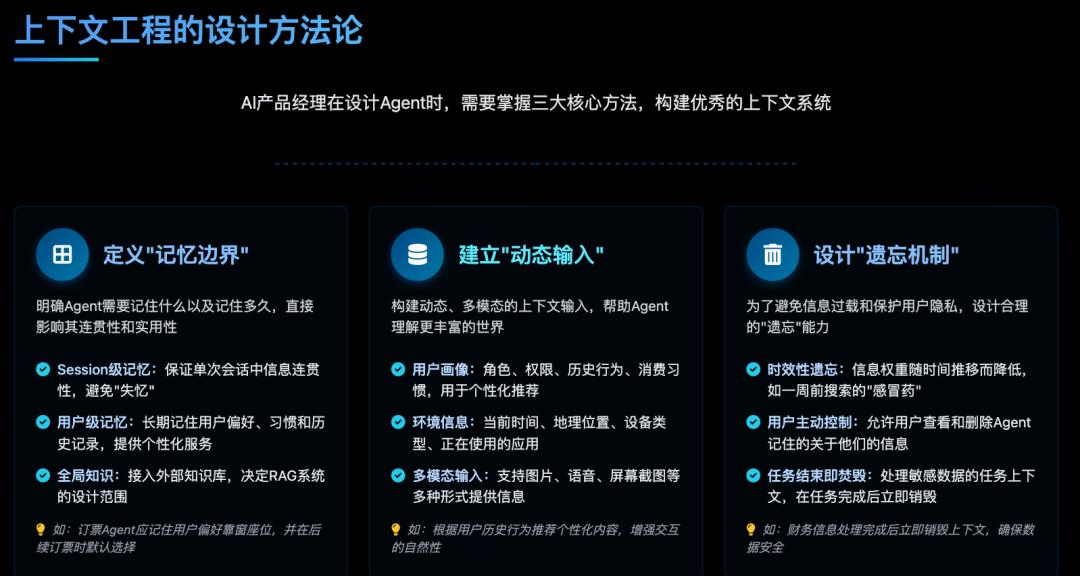

1. 定义Agent的“记忆边界”

你的Agent需要记住什么?记多久?这是首要问题。

Session级记忆: 对于一次性任务的Agent(如客服问答),至少要保证在单次会话中记忆是连贯的。

用户级记忆: 对于个人助手类Agent,需要长期记住用户的偏好、习惯、历史记录。比如,我每次订机票都选靠窗,一个好的订票Agent就应该在我第三次订票时,默认帮我锁定窗口位。

全局知识: Agent需要接入的外部知识库是什么?是全网信息,还是你们公司的内部文档?这个边界决定了RAG(检索增强生成)系统的设计。

2. 建立动态、多模态的上下文输入

静态的文本Prompt已经不够用了。未来的Agent需要能够理解一个更丰富的世界。

用户画像(User Profile): 用户的角色、权限、历史行为、消费习惯等。

环境信息(Environment): 时间、地理位置、设备类型(手机/PC)、正在使用的App。

多模态输入(Multi-modal): 用户发来的图片、语音、甚至屏幕截图。

想象一个电商Agent,如果它能知道:【用户A,女性,30岁,坐标上海,正在使用手机App,刚刚浏览了3款羊毛大衣,现在是晚上10点】,那么它推荐的产品和话术,将远比一句简单的“猜你喜欢”要精准得多。

3. 设计上下文的“遗忘机制”

和人一样,一个健康的AI系统也需要“遗忘”,否则可能会导致信息过载和隐私问题。

时效性遗忘: 比如,用户一周前搜索“感冒药”,现在这个信息对于推荐系统来说权重就应该降低了。

用户主动控制: 允许用户查看和删除Agent记住的关于他们的信息,这是对用户隐私的尊重,也是建立信任的关键。

任务结束即焚毁: 某些敏感任务(如处理财务数据)的上下文,应该在任务结束后立即销毁,不留痕迹。

4. 从“人机交互”到“人-机-环境”交互

优秀的产品设计,要让Agent融入到用户的真实工作流和生活流中。这意味着我们的视角要从单一的人机对话,扩展到更宏大的“人-机-环境”的协同。

我的手机Agent应该知道我的日历,当我收到一封“会议邀请”邮件时,它应该能自动检查我是否有空,并给出“接受”或“建议其他时间”的快捷按钮。它不是在等我下指令,而是基于它所处的“环境上下文”,主动为我服务。

四、 写在最后:上下文,是AI产品的“护城河”

未来一两年,大模型的性能会逐渐趋同,API的调用成本也会越来越低。届时,单纯依赖一个强大的LLM已经无法构成壁垒。

真正的竞争优势,在于你为Agent构建了多么深刻、独特且高效的上下文理解系统。

你的Agent比别人更懂你的用户吗?

你的Agent能接入别人没有的数据和知识吗?

你的Agent能在复杂的业务流程中,始终保持清晰的“记忆”和“认知”吗?

这些问题的答案,都指向上下文工程。它不像模型训练那样光鲜亮丽,它更像是冰山下的巨大主体,琐碎、复杂,但决定了Agent最终能抵达的高度。

就聊这么多。