AI Agent 落地血泪史,分享我的几点思考

最近一年,我几乎把所有精力都扑在了 AI Agent 的研发和落地上。踩过的坑、熬过的夜,都快能写成一本书了。

然而,从一个炫酷的 Demo 到一个能真正在业务中稳定运行、创造价值的“有效” Agent,中间隔着的,是无数个产品、技术和成本的权衡。

今天,我想和大家聊聊我在这方面的一些思考和实践总结,希望能为同样奋战在 AI 一线的你,带来一些实实在在的启发。

1、别把 Agent 当锤子,看什么都像钉子

我得出的第一个,也是最重要的一个结论就是:不要为所有事情都构建 Agent。

这听起来可能有点“反常识”。毕竟 Agent 的概念听起来那么强大,仿佛是解决一切复杂问题的银弹。刚开始我也是这么想的,恨不得把所有业务流程都“Agent 化”。但现实很快就给了我一记响亮的耳光。

Agent 的核心价值在于它的自主性和探索性,它能根据环境的实时反馈,自己决定下一步该干什么。这和我们更熟悉的、按预定流程执行的“工作流(Workflow)”有着本质区别。

在付出了高昂的 Token 成本和漫长的调试时间后,我总结出了一套启动 Agent项目前的“灵魂四问”,只有当答案都偏向肯定时,才值得投入资源:

(1)这事儿足够复杂和模糊吗?

Agent 最擅长的,是在一个充满不确定性的开放问题空间里“随机应变”。

如果一个任务的完整决策路径,你花点时间就能用流程图清晰地画出来,那我劝你,老老实实去构建一个明确的、节点可优化的工作流。

这样不仅成本效益高,而且稳定可控。强行上 Agent,只会是杀鸡用牛刀。

(2)这事儿的价值,配得上它的“钞能力”吗?

Agent 的探索过程,本质上是在燃烧 Token。每一次思考、每一次调用工具,都是真金白银的投入。

你必须评估,这个任务的最终产出价值,是否能覆盖掉它高昂的试错成本。

举个例子,如果你的场景是每单任务预算只有几毛钱的高并发客服系统,那么用传统工作流解决 80% 的常见问题,远比用 Agent 去追求 95% 的覆盖率要明智得多。

反之,如果你的目标是“不计成本,务必搞定”,那 Agent 就是你的不二之选。

(3)它的核心技能,有没有硬伤?

在让 Agent “大展拳脚”之前,必须先对它的核心能力进行“摸底考试”。

比如你想做一个代码 Agent,那它生成代码、调试代码、从错误中恢复的能力,就不能有明显的短板。任何一个环节的瓶颈,都会在 Agent 的循环调用中被无限放大,最终导致成本和延迟的指数级增长。

如果发现有硬伤,那就先缩小任务范围,简化目标,别贪大求全。

(4)搞砸了的代价,你承受得起吗?

Agent 的自主性是一把双刃剑。如果它犯错的代价极高,而且这个错误很难被及时发现(比如在金融交易、自动驾驶等领域),那你敢放手让它自己干吗?

我们当然可以通过设置“只读权限”、“增加人工审批环节”来降低风险,但这又会反过来限制 Agent 的自主性,让它变得没那么“智能”。

这个“信任”和“自主”的平衡点,非常微妙。

以AI生成短视频创意为例,它就完美地回答了这四个问题。从一个简单的主题需求到生成吸引人的短视频创意和脚本,这个过程足够复杂和模糊;一个优质的短视频创意可能带来大量流量和转化,其价值足以覆盖Token成本;大模型在创意构思、文案编写方面的能力已经相当成熟;最关键的是,视频创意可以先经过人工筛选再执行,有问题也能快速调整,风险可控。这就是一个绝佳的Agent应用场景。

2、大道至简,给你的 Agent 做“断舍离”

一旦确定了值得做的场景,我的第二个核心原则就是:大道至简,尽可能保持简单。

在我看来,Agent 的本质可以被概串括为一句话:“一个模型,拿着一堆工具,在一个环境里循环干活”。

拆解开来,就是三个最核心的组件:

环境(Environment): Agent 要去改变和感知的世界,比如一个代码库、一个操作系统、一个数据库。

工具集(Tools): Agent 能采取的行动,比如“读文件”、“写文件”、“执行 shell 命令”、“调用 API”。

系统提示(System Prompt): 我们给 Agent 下达的最高指令,定义了它的目标、行事准则和约束条件。

我踩过的最大的坑之一,就是一开始就把这个架构设计得过于复杂。各种记忆模块、规划模块、反思模块……层层嵌套,看起来很高级,但实际上迭代速度慢得惊人,稍微改动一个地方就可能引发雪崩效应。

后来我发现,仅仅围绕这三个最基本的组件进行迭代,就能获得最高的投入产出比。

真正的设计决策,其实就两件事:

第一,给 Agent 配备哪些恰到好处的工具?

第二,如何写好那段 Prompt,让它能清晰地理解自己的使命?

把这三个基本盘搭好,让 Agent 先跑起来,观察它的行为。然后再针对性地做优化。

比如,发现它反复执行同样的操作,那就增加缓存机制来降低成本;发现它调用多个工具时总是串行等待,那就改成并行调用来缩短延迟;发现用户不理解它在干嘛,那就优化 Agent 进展的可视化呈现,建立信任感。

记住,先让agent跑起来,再去做锦上添花的优化。一开始就追求完美,只会让你寸步难行。

3、像Agent一样思考

最后,我想分享一个在调试和优化过程中,我认为最有效的方法:像你的 Agent 一样思考。

我发现,很多开发者(包括我自己一开始)在构建Agent时,常常会陷入“人类的傲慢”。我们站在上帝视角,掌握着所有信息,所以当 Agent 做出一些在我们看来很“蠢”的决定时,第一反应往往是“这模型真笨!”

但我们忽略了一个最基本的事实:Agent 的整个世界,就只有那个小小的、不断滚动的上下文窗口(Context Window)。

它可能表现出令人惊叹的复杂行为,但在每一个决策瞬间,它所能依赖的,就只有那几千到几万个 Token 的信息。它不知道你刚刚在想什么,也不知道五分钟前发生过什么,除非这些信息明确地写在它的上下文里。

为了真正理解 Agent 的处境,我甚至做过一个现在想起来有点“神经质”的练习:

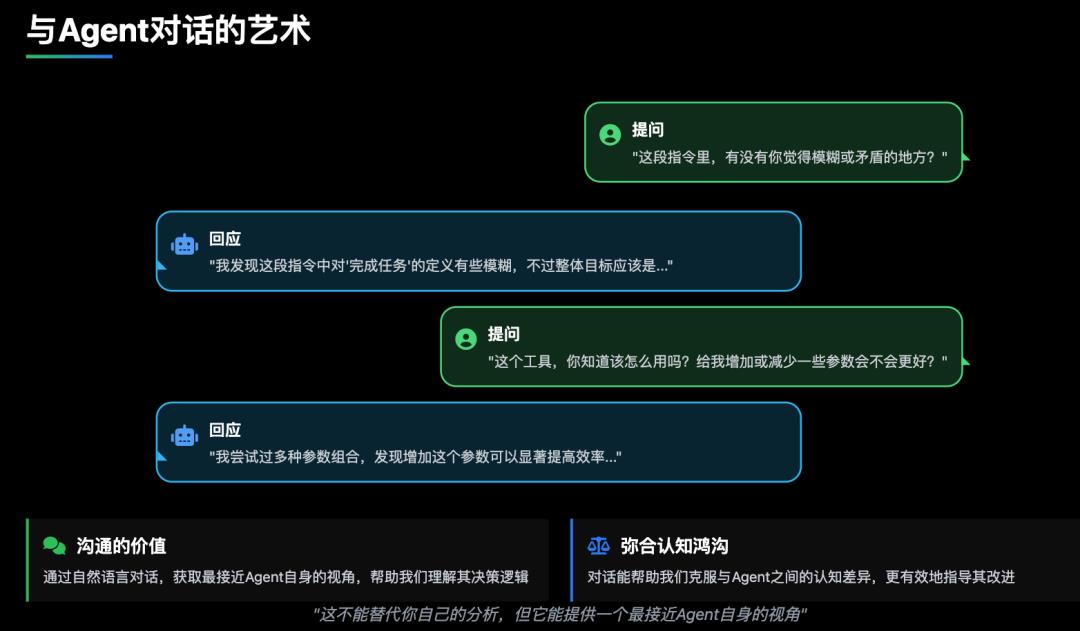

幸运的是,我们和 Agent 之间有共同的语言——自然语言。所以,多跟你的 Agent“聊聊”吧。把它的 System Prompt、工具描述、执行轨迹全都丢给一个顶级的语言模型,然后问它:

“这段指令里,有没有你觉得模糊或矛盾的地方?”

“这个工具,你知道该怎么用吗?给你增加或减少一些参数会不会更好?”

“分析一下这段执行记录,告诉我,你当时为什么会做出那个决定?如果我再给你提供什么信息,能帮你做得更好?”

这不能替代你自己的分析,但它能提供一个最接近 Agent 自身的视角,帮助我们弥合人类与 AI 之间的认知鸿沟。

写在最后

从高谈阔论到躬身实践,我对 AI Agent 的认知渐渐走完了一个循环。

它不是什么万能解药,而更像是一把“手术刀”——必须用在合适的场景中,才能真正发挥作用。

构建 AI Agent 不追求复杂,重要的是把握住核心三要素,做到“大道至简”。

优化也不只是代码层面的事,更需要一种“换位思考”式的人文关怀。